vendredi 8 juin 2018

Discussion avec Agnès Violeau pt.4

Agnès Violeau : Ton projet traite de l’écriture et de sa sauvegarde (au sens archivistique mais aussi numérique), au cœur d’une pratique, la tienne, qui questionne plutôt la déperdition, la disparition de l’image, de la source. Tu parles d’arborescences, d’architecture des données. Peut-on faire une association avec le traitement de l’information et/ou de la langue aujourd’hui, et la manière avec laquelle elle se simplifie en s’ancrant dans ces data centers ?

Daphné Le Sergent : Les archives regorgent d’images délivrant des informations.

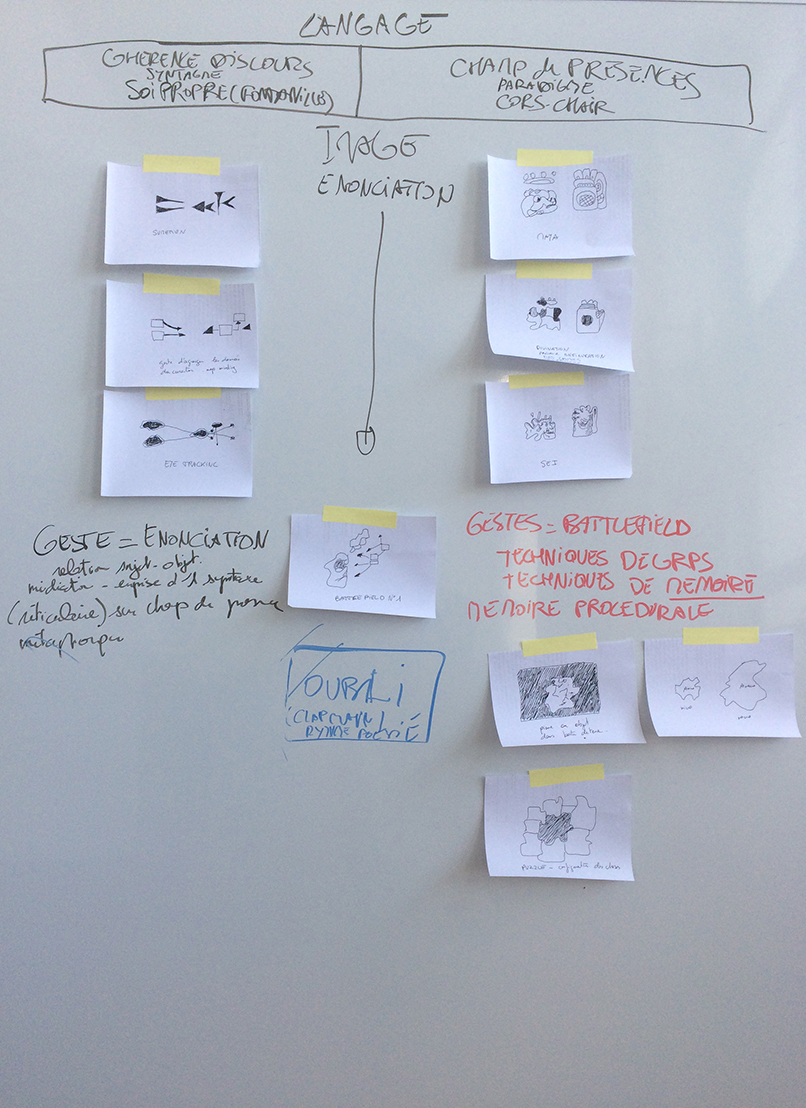

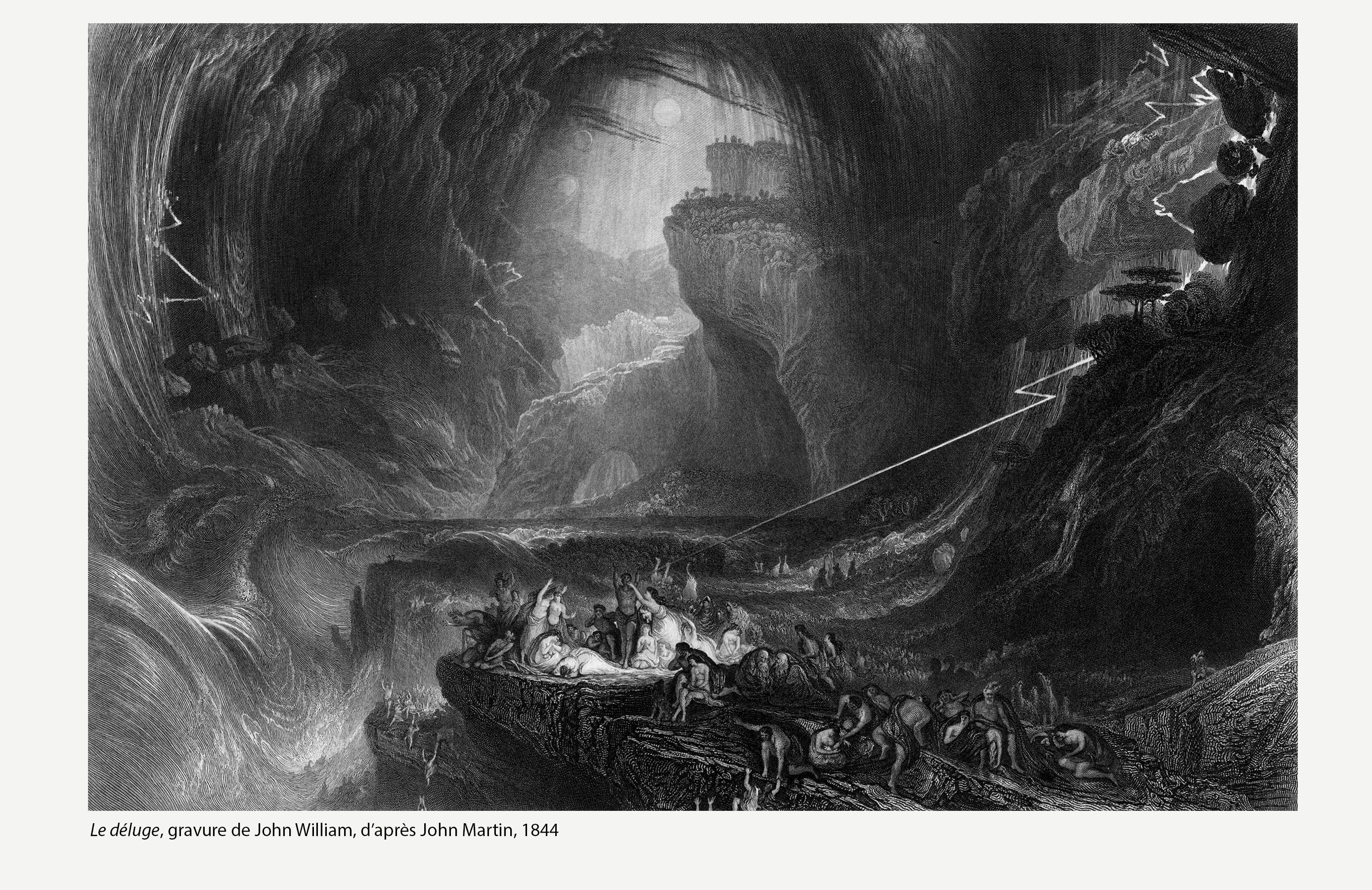

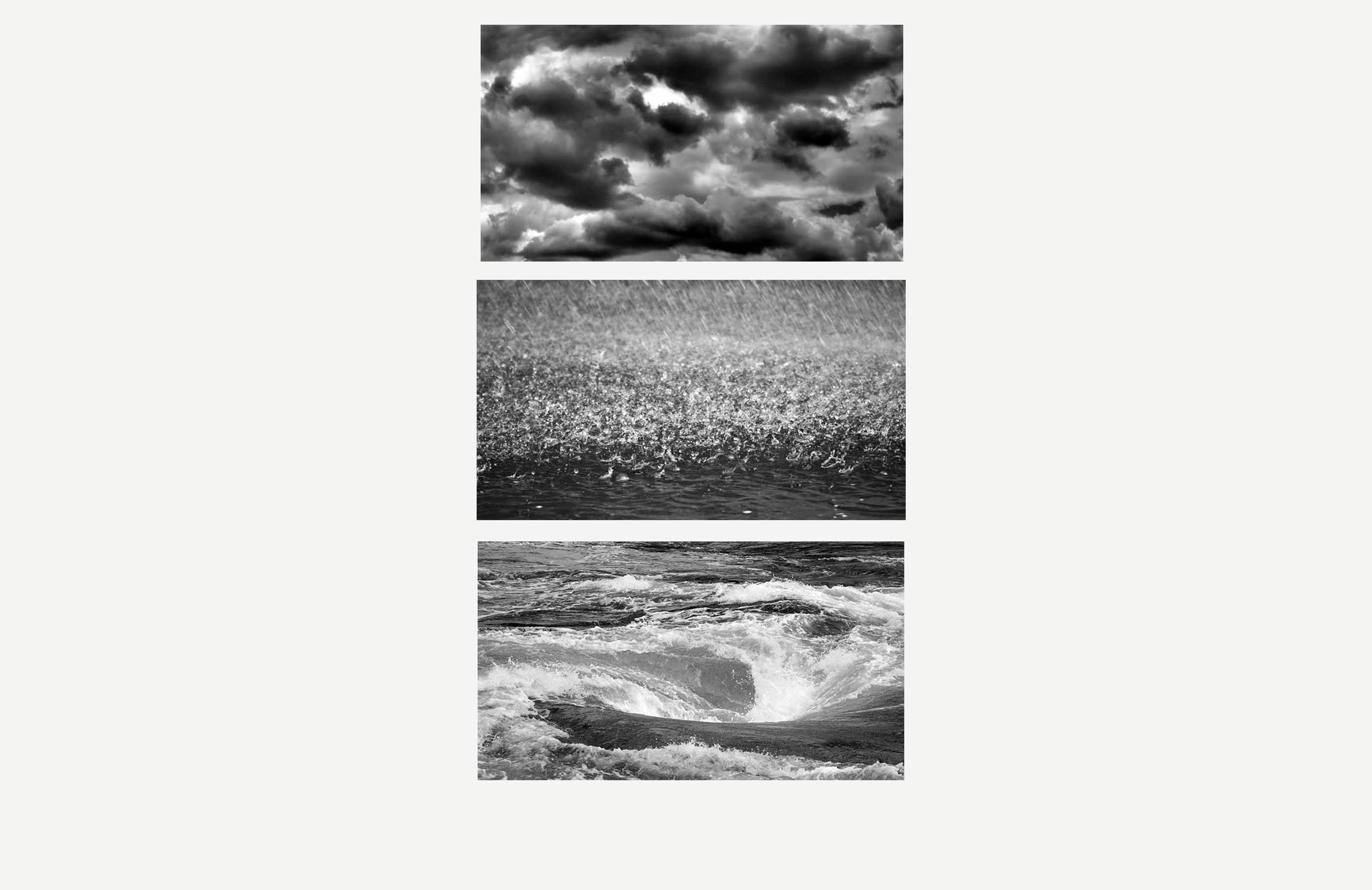

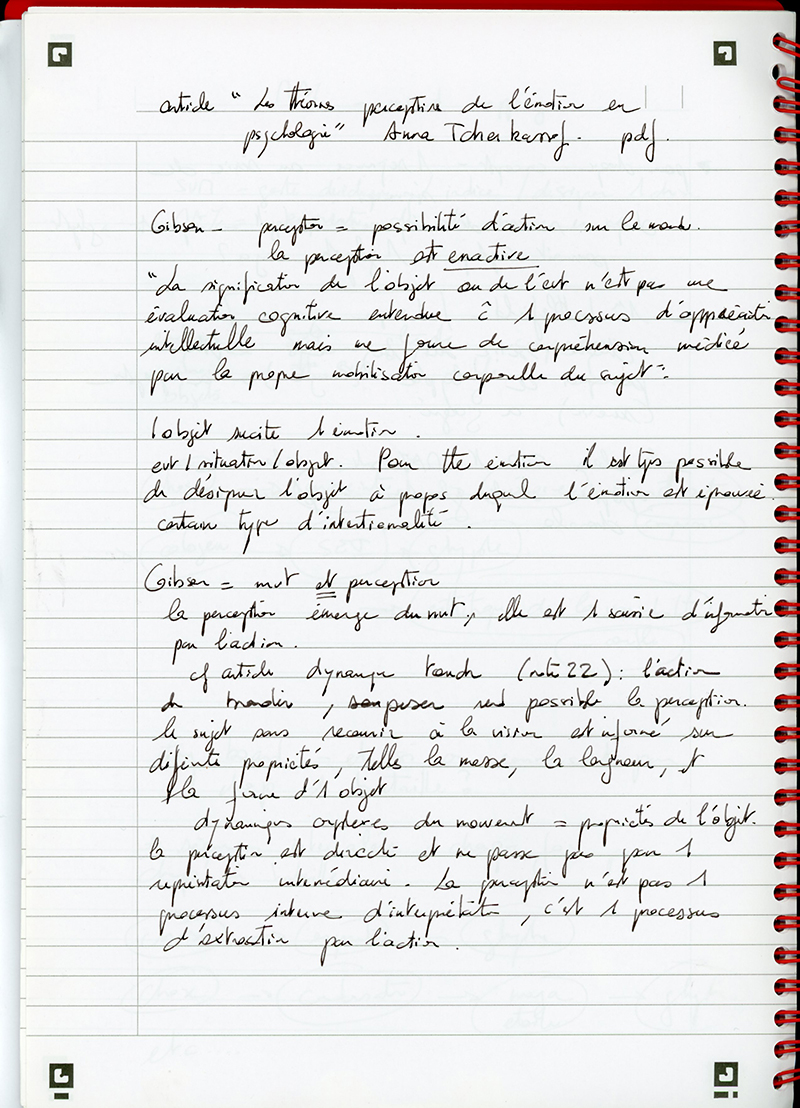

Mais concernant les archives personnelles, on glane des images ici et là, on les garde au fil de son parcours. Celles-ci en deviennent la trace, le souvenir. Elles ont une tonalité affective. Elles sont également un puissant activateur, un pont d’un temps à un autre. Quand je regarde une image qui a réveillé en moi une sensation particulière, en la retrouvant plus tard, cette émotion peut être rappelée – et avec elle tout le contexte autour. J’accumule en effet beaucoup d’images, notamment sur internet. Si les informations qu’elles contiennent motivent une série, c’est surtout le traitement par le dessin ou par des techniques mixtes qu’elles permettent de déployer. Par la dégradation au dessin ou par le traitement numérique, j’essaye de faire ressortir une matière, quelque chose de tactile. J’ai toujours en tête l’image de la mémoire que donne Platon, une empreinte dans une tablette de cire. C’est cela que je cherche à créer dans ces fichiers détériorés. L’image ne serait plus tant porteuse d’une information que d’un souvenir, comme si elle était la marque d’un contact passé entre le monde et moi. Ce qui est intéressant avec cette façon de travailler, c’est que deux images, porteuses de deux informations différentes peuvent arborer la même empreinte, présenter les mêmes configurations formelles, tant l’information a disparu, tant les formes se sont perdues. Elles se présentent comme deux empreintes similaires, résonnant de la même façon dans le souvenir. Et le travail d’archiviste devient un travail de poète. Entre la mémoire involontaire et la métaphore, il n’y a qu’un pas. Gaston Bachelard disait que le poète associe la mer et le ciel par métaphore car tous deux éveillent le même sentiment d’une étendue infinie, suscitent la même empreinte mémorielle.

C’est ma réponse d’artiste à cette double identité franco-coréenne qui comporte beaucoup d’ombres et de zones inconnues. Le présent ainsi transformé répond à un passé inconnu mais qui résonne encore en moi.

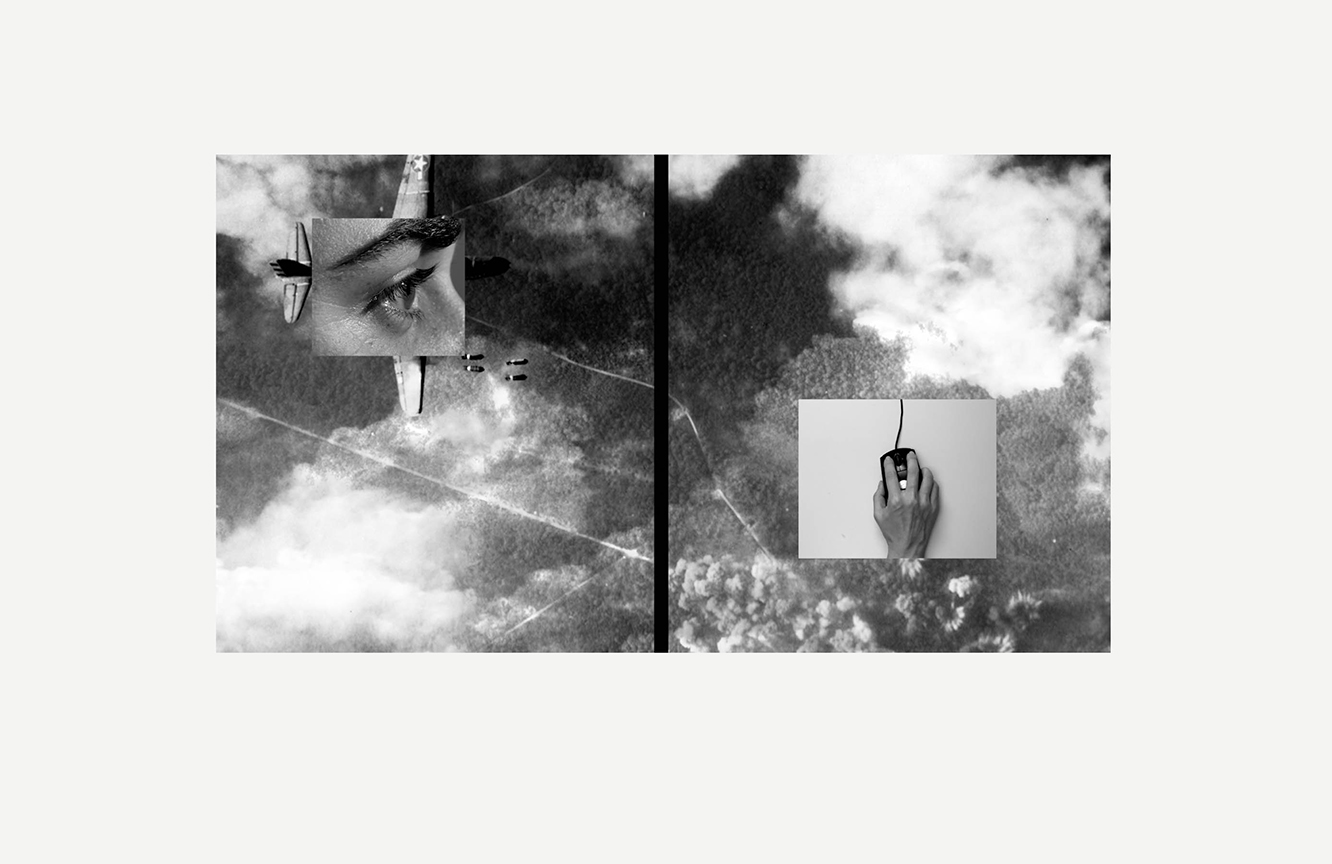

mercredi 6 juin 2018

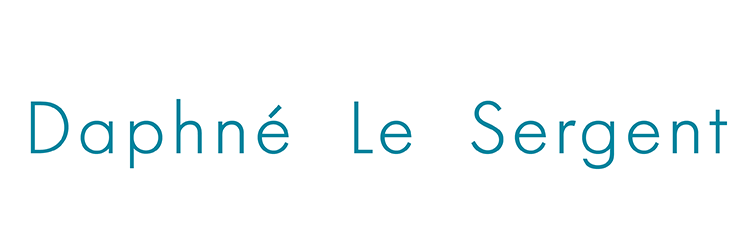

L’œil, moteur du visible

Conversation avec Geoffrey Tissier, ingénieur de recherche au LUTIN-USERLAB,

ergonomie, création d’interfaces innovantes, eye-tracking et commande par le regard

Daphné Le Sergent : Comment le regard évolue-t-il dans une image ?

Geoffrey Tissier : Il y a deux choses principales qui vont influencer le regard : des conditions extérieures et des conditions internes au regardant.

Si j’ai une image très contrastée avec un élément rouge au centre d’un fond gris, celui-ci va attirer l’œil immédiatement. Couleur vive, luminosité ou mouvement sont des traits de surface qui vont rendre l’objet visuellement saillant, propice à attirer le regard. À côté de cela, il y a l’intention avec laquelle je regarde cette image. Il est rare qu’on soit confronté à des images aussi simples que l’exemple que je viens de donner. En général, les images face à nous sont beaucoup plus complexes et je dois y chercher moi-même les informations. Cela va donc dépendre de mon intention de regard. Alfred Yarbus est le premier scientifique à avoir travaillé sur la question dès 1967. Il a mené des tests où il montre la même image à différentes personnes en faisant varier les consignes. Par exemple, il demande d’estimer le niveau social des personnages de la scène ou de deviner l’humeur des protagonistes. Selon la question, on ne s’intéresse pas aux mêmes éléments. On va s’attarder sur les vêtements, le mobilier ou d’autres détails pour la première demande tandis que pour la seconde, on va prêter attention aux visages, expressions ou éventuellement à leurs postures. Sur les planches des expériences reproduites ci-dessous, on s’aperçoit bien de la différence entre les trajectoires oculaires, même si certains indices visuels peuvent correspondre à plusieurs consignes.

Pour revenir aux conditions externes et à la question du mouvement, nous avons tous observé qu’un corps en mouvement va plus facilement capter l’œil. Les publicitaires l’ont bien compris, notamment sur internet, en accentuant le mouvement dans leurs clips, mais aussi en élevant le nombre d’images par seconde. On est souvent bien au-delà des 30 images/seconde avec une vitesse de 40, 50, voire 60 images/seconde – ce qui est assez exceptionnel pour des médias courants. Notre œil est physiologiquement conçu pour détecter le mouvement. Du point de vue évolutif, on l’explique par la détection des prédateurs par nos ancêtres les primates, ce qui fait que la vision périphérique va être plus sensible au mouvement que la vision centrale.

Daphné Le Sergent : Y a-t-il des règles pour le déplacement du regard ?

Geoffrey Tissier : Cela reste difficile à évaluer car les variations sont énormes selon le support visuel ou mon intention face à l’image. Mais on a pu dégager en effet une sorte de logique. Dans un premier temps, on va scanner grossièrement l’image afin d’en retirer les informations principales. On va par exemple s’intéresser à la résolution spatiale. Si je me trouve face à une voiture garée sur du gazon, il y a trois éléments : la voiture, le gazon et le ciel. Mais, pour ces deux derniers objets – ciel et gazon – on observe une faible « résolution spatiale », c’est à dire qu’il y aura peu de variations dans la nuance de leurs teintes, peu de variations dans les bleus et les verts. La voiture, au contraire, présente une multitude de détails, d’arêtes, de variations de couleurs et de lumière sur sa carrosserie.

L’œil va donc repérer les principaux éléments de l’image pour avoir une idée générale et pour savoir là où il doit chercher les informations requises par sa tâche, comme par exemple de savoir qui est au volant. C’est une construction – ou une arborescence : je pars d’une idée vague de l’image puis au fur et à mesure je vais chercher dans le détail pour répondre à mon objectif. Et ces objectifs sont conscients ou inconscients. On ne regarde pas toujours les choses avec un objectif clair mais on ne les regarde pas pour rien non plus. Il y a toujours une raison qui va orienter notre regard.

Daphné Le Sergent : Quelles sont les activités du LUTIN/Userlab ?

Geoffrey Tissier : Le LUTIN/Userlab est une plate-forme de recherche avec de nombreux pôles et axes différents. Cela touche à beaucoup de domaines allant de l’éducation à l’intelligence artificielle même si notre point de ralliement reste l’ergonomie cognitive. En tant que laboratoire public, nous accueillons des travaux de qualité du point de vue scientifique, travaux qui vont ouvrir de nouveaux champs d’application. Nous privilégions également le lien avec d’autres organismes, la recherche ne se fait pas sans communication et échanges.

Daphné Le Sergent : Quel est ton rôle au LUTIN/Userlab?

Geoffrey Tissier : Je suis l’ingénieur du laboratoire. Je suis le référent pour toutes les questions techniques et l’utilisation des appareils de mesure (électro-encéphalographie, réponses électrodermales, motion capture). Cela requiert des connaissances techniques mais aussi de savoir interpréter leurs données. C’est là le nœud de la recherche. Rien n’est plus facile que de récolter une montagne de données, mais il faut savoir comment les utiliser, quelles nuances apporter, comment de petites variations dans les temps de regard ou dans l’amplitude des saccades peuvent par exemple m’indiquer l’état émotionnel d’un lecteur.

Daphné Le Sergent : J’avais été impressionnée par le système de commande par le regard que tu as mis en place pour déplacer une image, faire défiler un texte ou scroller dans une page web, rien qu’avec les yeux.

Geoffrey Tissier : Tout part d’un projet en cinéma 3D où on rencontre de nombreuses difficultés dans la mise en scène puisqu’on a constamment deux caméras pour faire un plan, une caméra étant dédiée à chaque œil dans un principe stéréoscopique. Selon l’écartement des deux caméras, on va amplifier ou aplatir l’effet de relief 3D, travailler les effets de surgissement des objets au premier plan. Cette distance va également demander des réglages d’orientation des caméras par rapport à l’objet filmé. Gérer ces questions techniques en continu durant un tournage se révèle être un vrai défi alors que nos yeux font ce travail continuellement et de façon tout à fait naturelle. Si nous savions reproduire leur mécanisme, cela permettrait une meilleure flexibilité et réactivité de la prise de vue en 3D. Le challenge technique était donc de copier le mouvement des yeux et de l’appliquer à celui des deux caméras. C’est dans ce cadre que j’ai élaboré un prototype peu coûteux pour tester l’idée. Peu à peu, au fur et à mesure des étapes, j’ai testé ce système sur une image informatique, comme si ce que je voyais à l’écran était l’image captée par la caméra. L’image glissait et défilait selon le déplacement du regard. Il n’y avait plus qu’à développer ce principe de commande par le regard. Aujourd’hui, cela peut avoir des applications très variées, notamment pour les personnes handicapées ou dans les jeux vidéo. C’était un défi technique et nous sommes les seuls à pouvoir le faire dans le monde avec une telle fluidité.

Daphné Le Sergent :Tu m’avais aussi décrit les différentes méthodes développées pour écrire avec le regard et j’avais été étonnée que la fiction de « géopolitique de l’oubli » soit déjà si réelle. Pourrais-tu y revenir ?

Geoffrey Tissier : Il existe plusieurs interfaces permettant d’écrire avec les yeux. Je te propose ici quelques exemples qui me semblent intéressants.

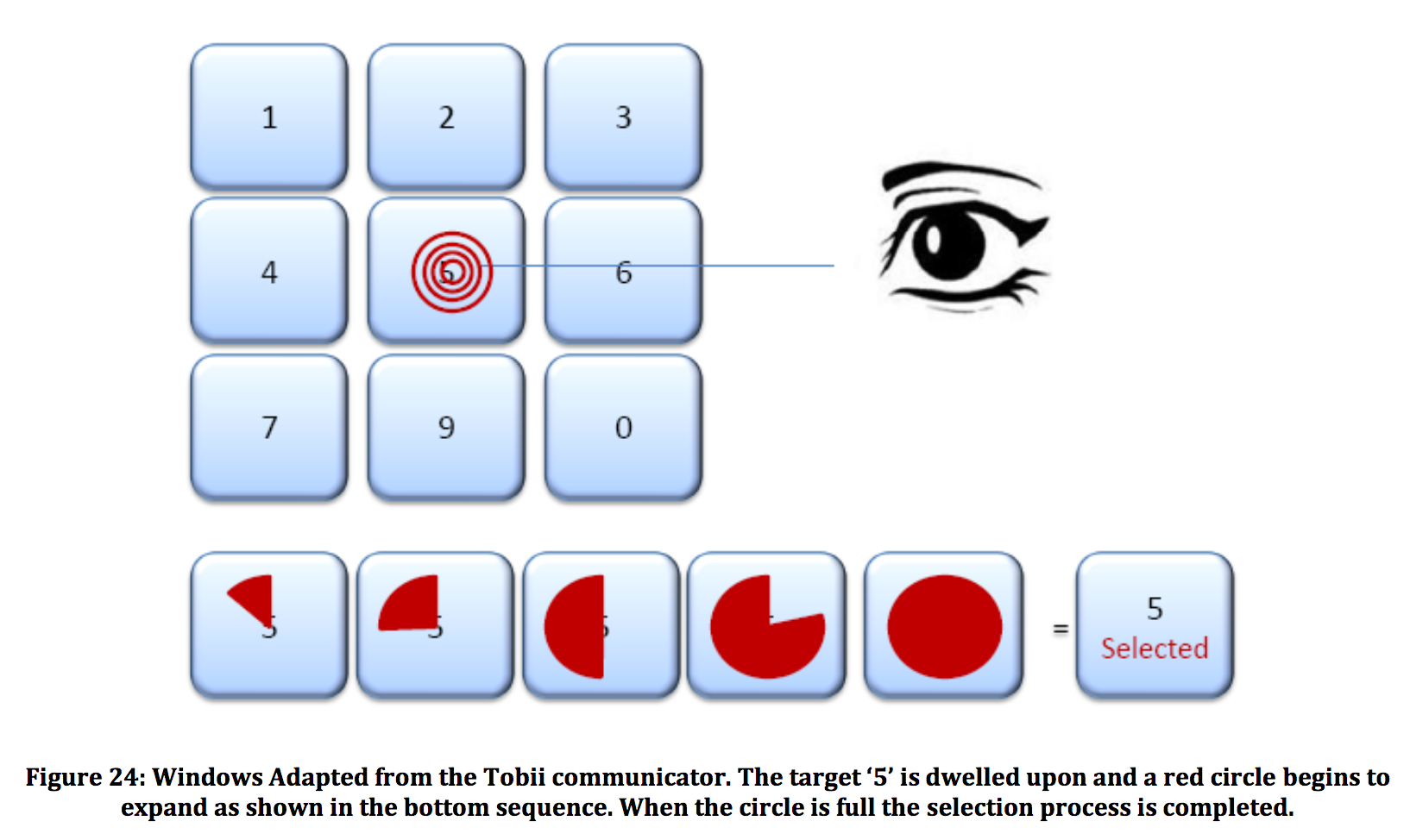

Cette première interface repose sur la technique du « dwell time ». Il s’agit d’une commande élémentaire où on va déclencher l’action si on maintient le regard fixé un certain temps sur l’une ou l’autre des touches. L’avantage de cette méthode est sa simplicité. On comprend immédiatement son fonctionnement. Son inconvénient est que ce comportement – poser le regard fixement et longtemps à un endroit – n’est pas naturel. Pour faire un chiffre, cela reste facile, une série de chiffres peut être difficile à réaliser si mon attention est distraite par l’extérieur et que je détourne rapidement le regard. A l’inverse, on parle de « fausse détection ». L’appareil répond alors que je regardais les touches sans volonté de les actionner. Ce problème est bien connu du milieu, on l’appelle « Midas touch », suite à l’histoire du roi Midas qui transformait en or tout ce qu’il touchait. Les yeux sont faits pour recevoir de l’information et non pour en produire comme c’est le cas dans cette méthode. Dans ce genre de système, il s’installe un conflit permanent entre un œil qui regarde et un œil qui commande.

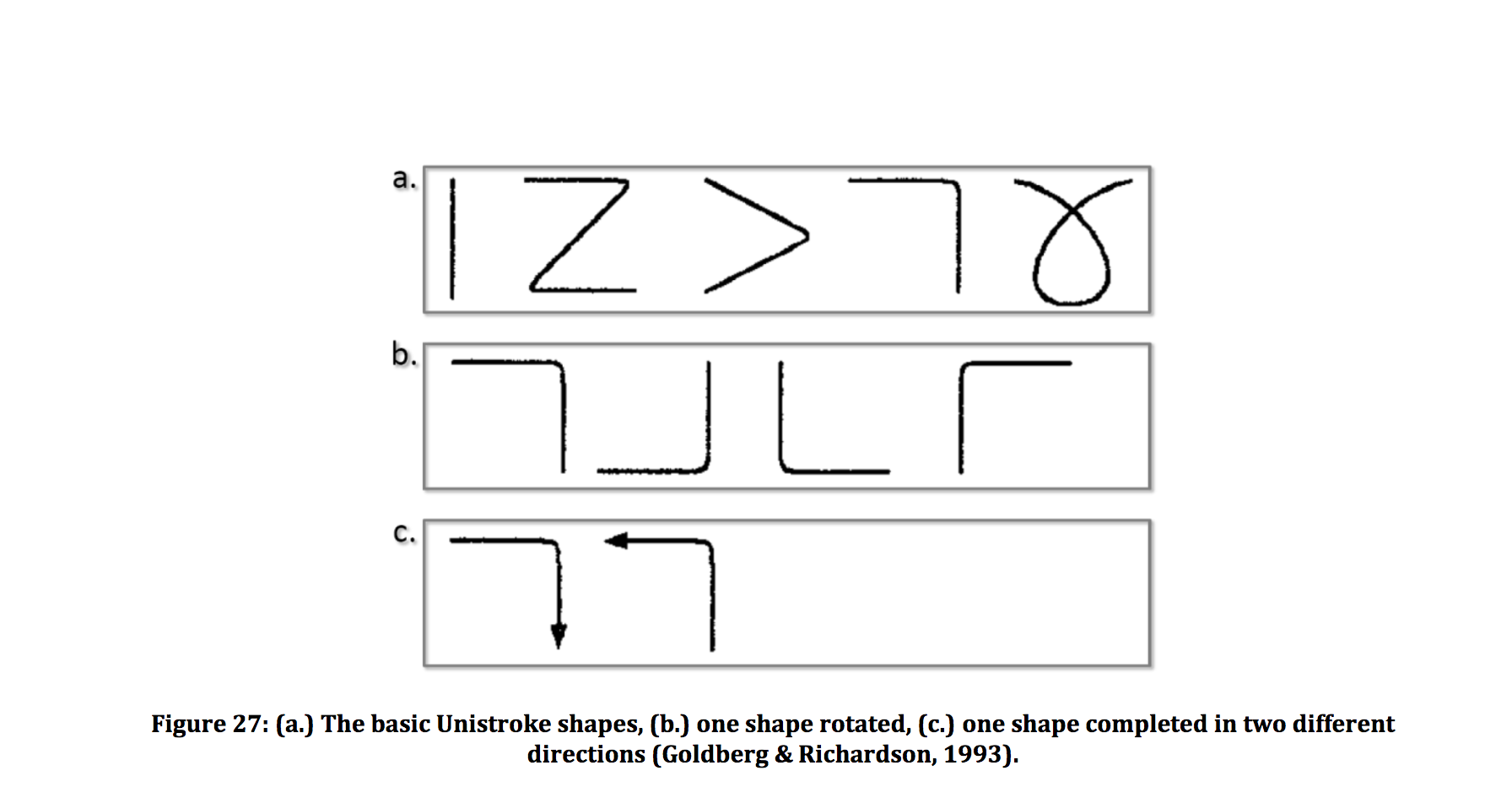

Parmi les méthodes plus évoluées, on peut aussi mentionner cet alphabet spécialisé. À chaque signe correspond une lettre, comme si nous la dessinions des yeux. Mais il est par exemple compliqué de dessiner la lettre « a ». Cet alphabet propose donc des signes simplifiés, plus faciles à tracer, composés de segments de même taille, horizontaux et verticaux. Un des grands inconvénients de ce système est qu’il nécessite un apprentissage. De plus, il n’est pas du tout naturel de réaliser un mouvement oculaire dans le vide, sans support pour le regard. Par exemple, si j’observe une route au loin sur laquelle passe une voiture, mes yeux vont suivre le mouvement rectiligne du véhicule sans aucune difficulté. Mais si je dois reproduire ce mouvement oculaire sans support, cela m’est impossible.

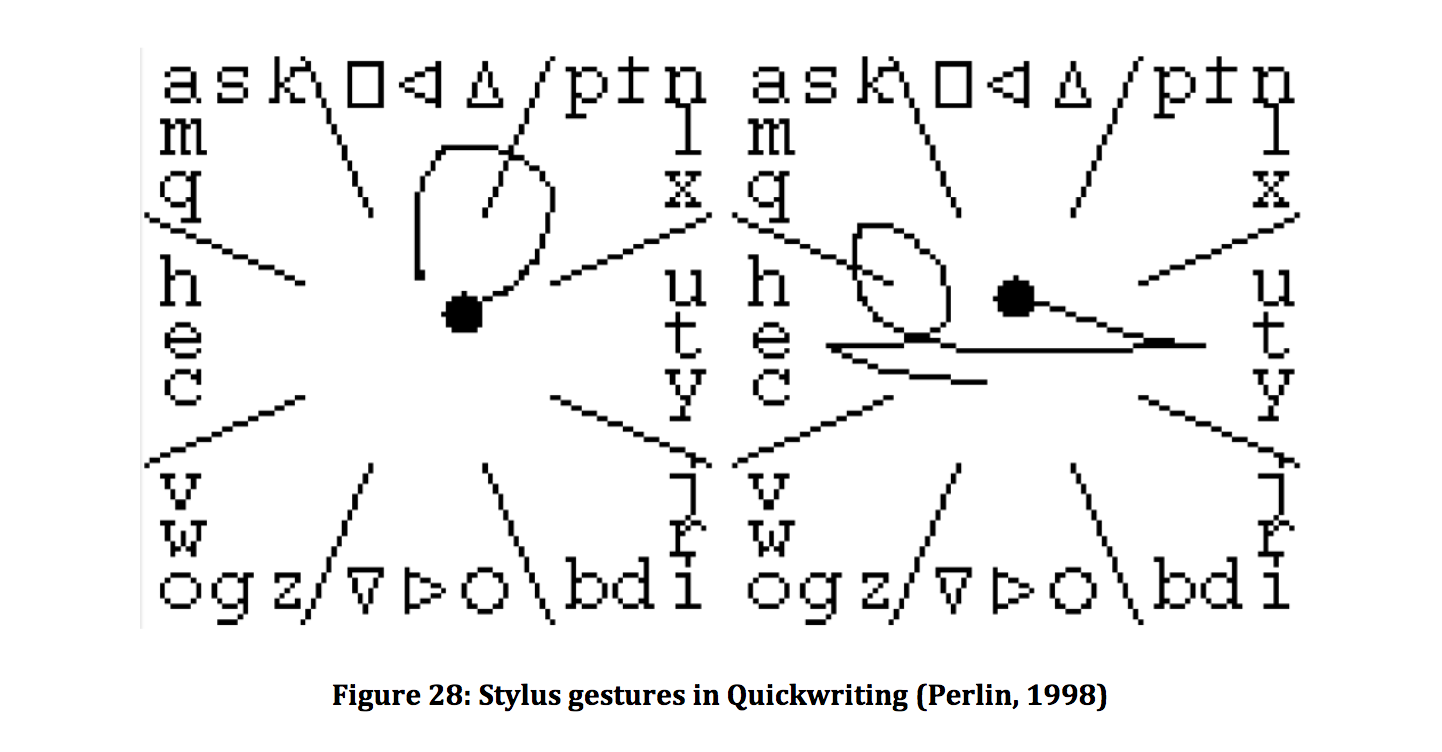

Cet autre exemple évoque les anciens claviers des téléphones portables. Le carré face à nous est divisé en plusieurs zones. Dans chaque zone, se trouve un groupe de lettres. En premier lieu, on va regarder la zone qui contient la lettre que l’on souhaite activer. Puis le regard va se déplacer à nouveau dans le cadran pour désigner la position de cette lettre par rapport aux autres lettres du même groupe. Si je veux ici sélectionner « w », je vais regarder dans le coin inférieur gauche, où se trouve la lettre choisie. Mais il n’y a pas que le « w » dans cette zone, il y a aussi les lettres « v » et « o ». Comme « w » est placé au milieu de ces deux lettres, mon regard va se déplacer au milieu du cadran, dans la zone des lettres « h », « e », « c ». Si j’avais voulu sélectionner le « v », mon regard aurait dû se positionner dans la zone supérieure « a », « m », « q ». Une fois qu’on a compris le principe, l’avantage de cette méthode est qu’elle est assez agréable d’utilisation, qu’elle ne contraint pas le mouvement de l’œil à la fixité.

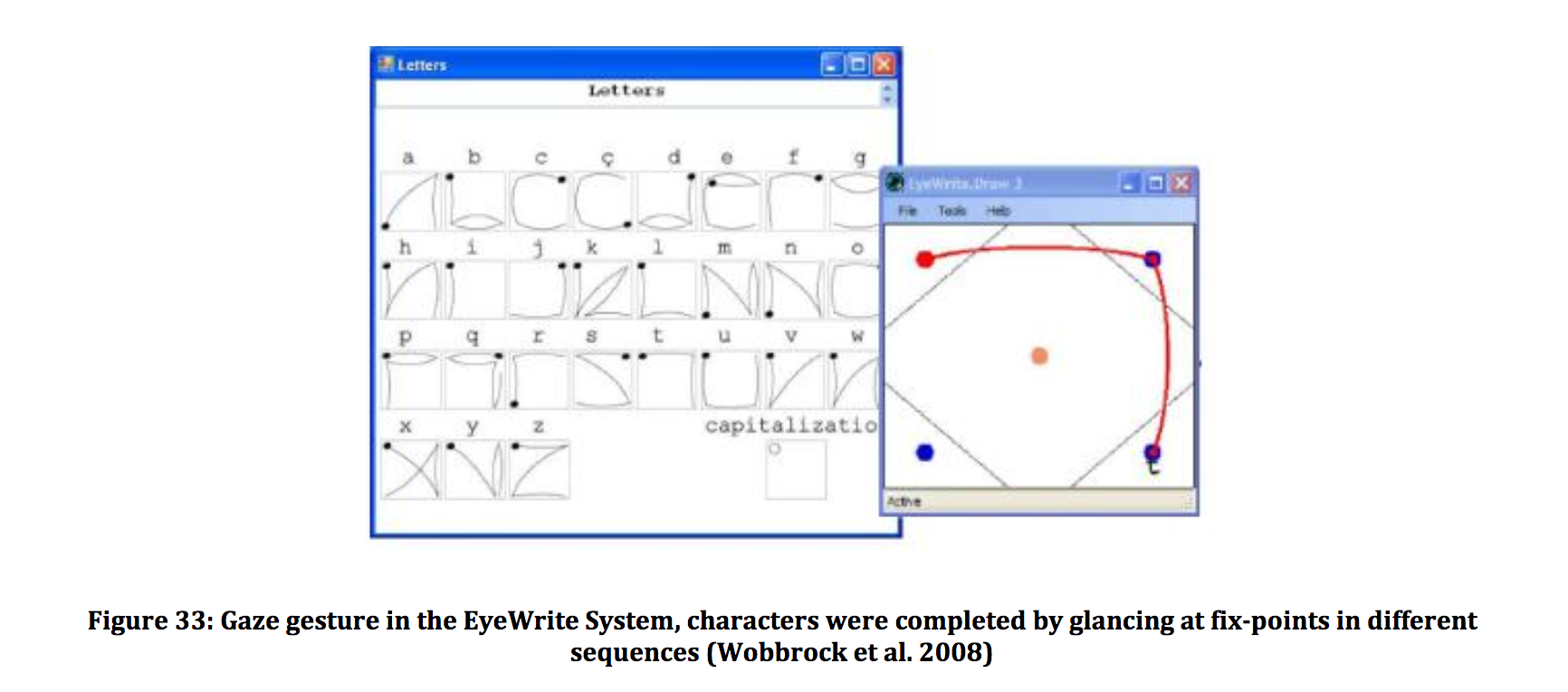

Ici également nous avons affaire à un alphabet spécialisé. Il demande au regard de relier des points, ce qui est plus facile que de tracer des lettres dans le vide.

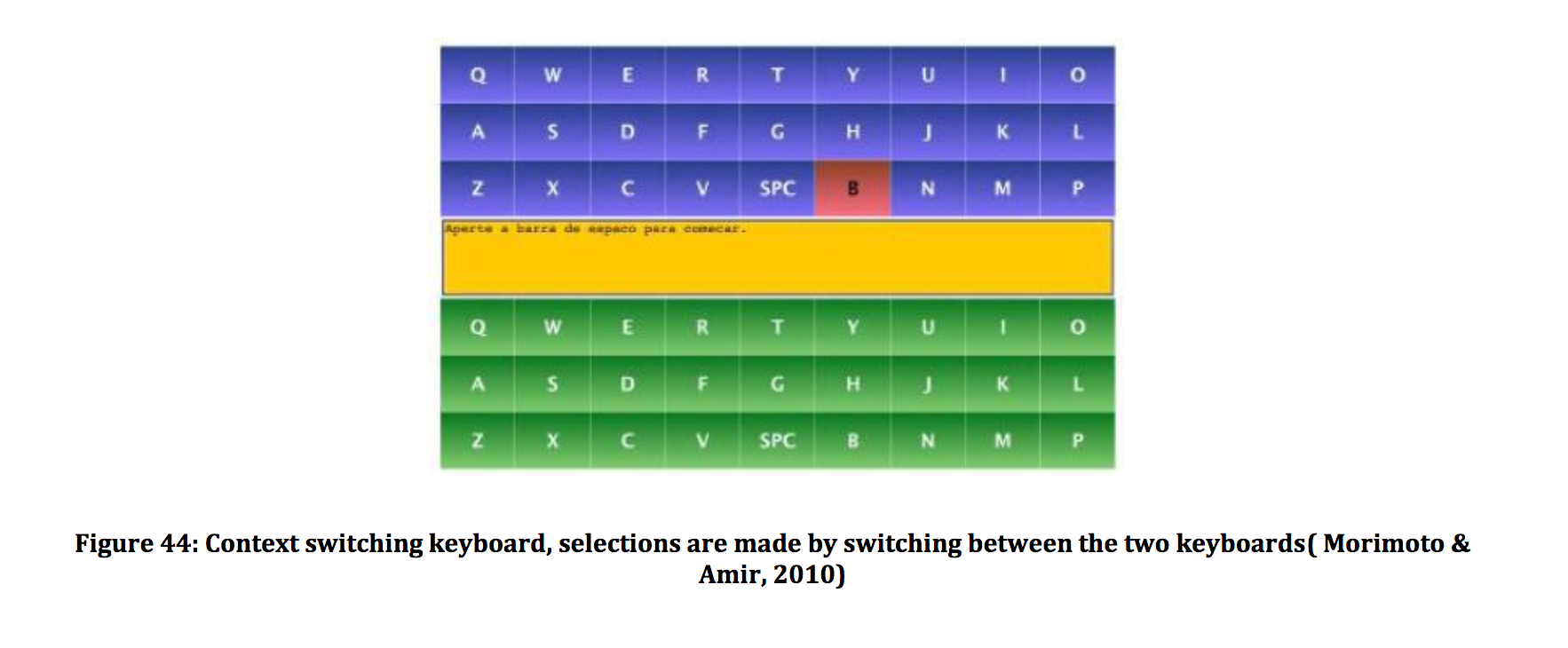

Cette méthode est simple et maline. On est face à deux claviers séparés, et on alterne la saisie en passant d’un clavier à l’autre. C’est lorsqu’on franchit la bande jaune qui les sépare qu’on valide en même temps la dernière lettre saisie. Si on franchissait la ligne pour revenir sur le même clavier, cela serait beaucoup moins confortable pour le regard. Ici, il y a des trajectoires fluides et continues.

Daphné Le Sergent : Penses-tu que ces applications seront commercialisées bientôt ?

Geoffrey Tissier : Tout dépend à qui on s’adresse. Pour le moment, rien ne vaut l’action des mains sur un clavier physique pour produire des lettres. Cependant, pour une personne handicapée, ou par exemple pour une tâche simultanée qui occupe déjà les mains, c’est intéressant. Ce n’est pas parce qu’on a une modalité d’interaction en plus, qui ouvre de nouvelles possibilités par commande visuelle, que les autres modalités n’existent plus.

Source des visuels : Sélection strategies in gaze interaction, thèse de doctorat d’Emilie Mollenbach, Loughborough University, Angleterre, 2010.